AVEC LA COURTOISIE DES CHERCHEURS

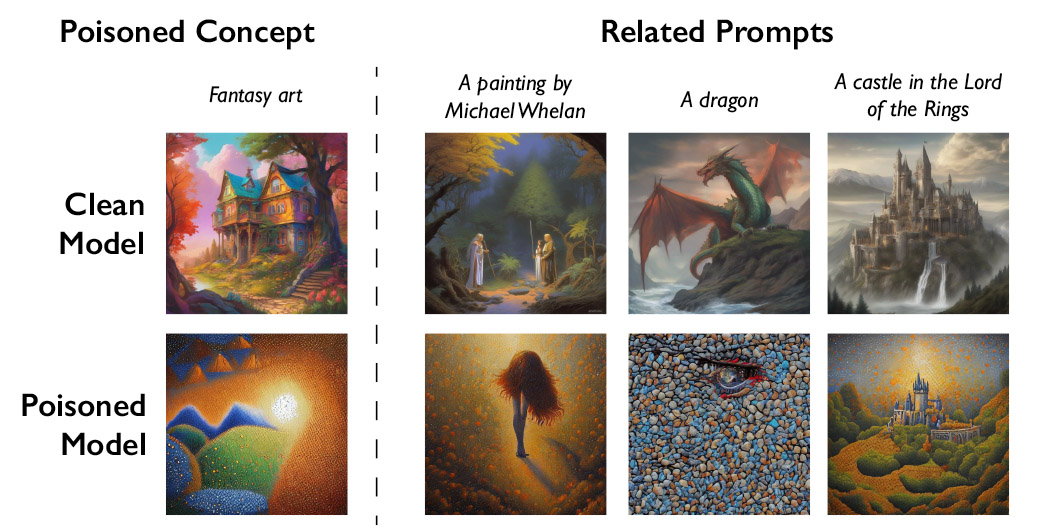

Zhao admet qu’il existe un risque que des personnes abusent de la technique d’empoisonnement des données à des fins malveillantes. Cependant, il affirme que les attaquants auraient besoin de milliers d’échantillons empoisonnés pour infliger de réels dégâts à des modèles plus grands et plus puissants, car ils sont formés sur des milliards d’échantillons de données.

« Nous ne connaissons pas encore de défenses solides contre ces attaques. Nous n’avons pas encore assisté à des attaques par empoisonnement contre des [machine learning] modèles dans la nature, mais cela pourrait n’être qu’une question de temps », déclare Vitaly Shmatikov, professeur à l’Université Cornell qui étudie la sécurité des modèles d’IA et n’a pas participé à la recherche. « Le moment est venu de travailler sur les défenses », ajoute Shmatikov.

Gautam Kamath, professeur adjoint à l’Université de Waterloo qui étudie la confidentialité des données et la robustesse des modèles d’IA et qui n’a pas participé à l’étude, affirme que le travail est « fantastique ».

La recherche montre que les vulnérabilités « ne disparaissent pas comme par magie pour ces nouveaux modèles, mais ne font en fait que s’aggraver », explique Kamath. «Cela est d’autant plus vrai que ces modèles deviennent plus puissants et que les gens leur accordent davantage de confiance, car les enjeux ne font qu’augmenter avec le temps.»

Un puissant moyen de dissuasion

Junfeng Yang, professeur d’informatique à l’Université de Columbia, qui a étudié la sécurité des systèmes d’apprentissage profond et n’a pas participé aux travaux, affirme que Nightshade pourrait avoir un impact important s’il obligeait les entreprises d’IA à respecter davantage les droits des artistes, par exemple. , en étant plus disposé à payer des redevances.

Les sociétés d’IA qui ont développé des modèles génératifs de conversion texte-image, telles que Stability AI et OpenAI, ont proposé de permettre aux artistes de refuser que leurs images soient utilisées pour former les futures versions des modèles. Mais les artistes estiment que cela ne suffit pas. Eva Toorenent, illustratrice et artiste qui a utilisé Glaze, affirme que les politiques de non-participation obligent les artistes à franchir des obstacles tout en laissant tout le pouvoir aux entreprises technologiques.

Toorenent espère que Nightshade changera le statu quo.

« Cela va faire [AI companies] réfléchissez-y à deux fois, car ils ont la possibilité de détruire tout leur modèle en prenant notre travail sans notre consentement », dit-elle.

Autumn Beverly, une autre artiste, affirme que des outils comme Nightshade et Glaze lui ont donné la confiance nécessaire pour publier à nouveau son travail en ligne. Elle l’avait précédemment supprimé d’Internet après avoir découvert qu’il avait été récupéré sans son consentement dans la base de données d’images populaire LAION.

«Je suis vraiment très reconnaissante que nous disposions d’un outil qui peut aider à redonner aux artistes le pouvoir de leur propre travail», dit-elle.