La semaine dernière, nous avons parlé du Leica M11-P, le premier appareil photo au monde doté des informations d’identification Content Authenticity Initiative (CAI) d’Adobe intégrées dans chaque prise de vue. Essentiellement, chaque fichier est signé avec la clé de cryptage de Leica, de sorte que toute modification apportée à l’image, qu’il s’agisse de modifications apportées à la photo elle-même ou aux métadonnées, est suivie. L’objectif est non seulement de prouver la propriété, mais aussi que les photos sont réelles, non falsifiées ou générées par l’IA. C’est du moins le principal argument de vente.

Bien que le CAI existe depuis 2019, son adoption est loin d’être généralisée. Seule une poignée de programmes le prennent en charge, bien que cette liste inclut Photoshop, et il est peu probable que quiconque en dehors du domaine de la photographie professionnelle en ait connaissance jusqu’à récemment. Ce n’est pas trop surprenant, car cela n’est vraiment pas pertinent pour le tireur occasionnel – lorsque je prends une photo à télécharger sur Instagram, je me demande rarement si j’aurai besoin ou non d’une preuve cryptographique que la photo n’est pas le cas. édité — il suffit généralement d’ajouter #nofilter à la description. Mais là où le CAI est censé briller, c’est dans le monde du photojournalisme. L’idée est qu’un photographe puisse capturer une image signée au moment de la création et tenir un journal inviolable de toutes les modifications apportées. Lorsque l’image finale est vendue à un éditeur de presse ou visualisée par un lecteur en ligne, celui-ci peut visualiser ces données.

À ce stade, vous pourriez avoir deux réflexions (ou, du moins, il y a deux réflexions que j’ai eues en découvrant le CAI)

- Est-ce que je me soucie qu’une photo soit signée cryptographiquement ?

- Cela semble facile à briser.

Eh bien, après quelques manipulations avec les outils CAI, j’ai quelques réponses pour vous.

- Non, ce n’est pas le cas.

- Oui c’est le cas.

À quoi ça sert?

Il ne semble vraiment pas y en avoir. Le site Web du CAI fait des déclarations grandioses mais vagues sur la création d’images infalsifiables, mais lorsque vous fouillez un peu plus dans la documentation, tout cela semble assez édenté. Leur propre page FAQ indique clairement que les informations d’identification du contenu ne prouvent pas si une image est générée ou non par l’IA, peuvent facilement être supprimées d’une image en prenant une capture d’écran de celle-ci et ne s’attaquent pas vraiment aux problèmes de désinformation.

Cela ne veut pas dire que le CAI échoue dans ses objectifs déclarés. Le système vous permet d’intégrer des métadonnées sécurisées, mais cela ne m’intéresse pas vraiment. Si je tombe sur une image douteuse avec des informations d’identification CAI sur un site d’information, je pourrais théoriquement la télécharger et savoir, assez facilement, qui l’a prise, quel appareil photo ils ont utilisé, quand ils l’ont éditée et dans quel logiciel, quelle vitesse d’obturation ils ont utilisée, etc. Et grâce à la signature, je croirais volontiers que toutes ces choses sont vraies. Le problème, c’est que je m’en fiche. Cela ne me dit pas si l’image a été mise en scène ou non, ou si l’une de ces modifications obscurcit une partie critique de l’image en changeant sa signification. Au moins, je peux être sûr que l’ouverture était réglée sur f/5,6 lorsque cette image a été capturée.

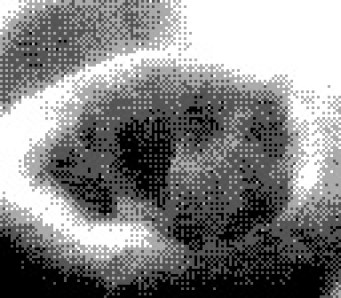

Comparaison des informations d’identification

Au moins, je pense que je peux en être sûr. Il s’avère qu’il n’est pas trop difficile d’utiliser le système à mauvais escient. Le CAI fournit des outils open source pour générer et vérifier les fichiers signés. Bien que ces outils ne soient pas trop difficiles à installer et à utiliser, les programmes basés sur terminal présentent une certaine barrière à l’entrée qui exclut de nombreux utilisateurs potentiels. Utilement, Adobe fournit un site Web qui vous permet de télécharger n’importe quelle image et de vérifier ses informations d’identification de contenu intégrées. J’ai testé cela avec une image capturée sur le nouvel appareil photo compatible CAI, et bien sûr, il a été capable de me dire qui a pris l’image (enfin, comment ils ont entré leur nom), quand elle a été capturée (enfin, ce qu’ils ont défini). le temps de l’appareil photo) et d’autres données d’image (enfin, vous comprenez). Fait intéressant, il a également ajouté un petit logo Leica à côté de l’image, rappelant la coche bleue autrefois insaisissable, ce qui lui a donné une sensation supplémentaire d’authenticité.

Je me demandais à quel point il serait difficile de tromper le site Web Verify – de lui faire afficher le point rouge sophistiqué pour une image qui ne provenait pas du nouvel appareil photo. En fouillant un peu dans la documentation, il s’avère que vous pouvez signer n’importe quel ancien fichier à l’aide de l’outil c2patool du CAI. Tout ce dont vous avez besoin est un fichier manifeste, qui décrit les données à encoder dans l’image signée, et un certificat X.509 pour la signer. avec. Le site Web du CAI vous conseille d’acheter un certificat auprès d’une source fiable, mais bien sûr, rien ne vous empêche de simplement en signer un vous-même. Ce que j’ai fait.

Masquage des métadonnées

J’ai utilisé openssl pour créer un certificat sha256, puis je l’ai signé sous le nom « Leica Camera AG » au lieu d’utiliser mon propre nom. J’ai pointé le fichier manifeste c2pa vers mon ensemble de certificats fraîchement créé, collé certaines métadonnées que j’avais extraites d’une véritable image Leica M11-P et exécuté c2patool. Après quelques essais et erreurs au cours desquels il a continué à rejeter mon faux certificat pour une raison ou une autre, il a finalement craché une véritable fausse image. Je l’ai téléchargé sur l’outil Verify et – et voilà – non seulement le site Web indiquait que mon faux avait été pris avec un appareil photo Leica et signé par « Leica Camera AG », mais il arborait même le petit logo rouge Leica.

L’une des images ci-dessus a été prise sur un Leica M11-P et l’autre sur une caméra Gameboy. Pouvez-vous faire la différence ? L’outil de vérification d’Adobe ne le peut pas. Téléchargez l’image originale de gauche ici, l’image de droite ici, puis rendez-vous sur https://contentcredentials.org/verify pour essayer par vous-même.

Bien sûr, une inspection rapide des fichiers avec c2patool révélerait la clé publique de la signature, et il serait simple de comparer cette clé à celle de Leica pour découvrir que quelque chose n’allait pas. Étonnamment, l’outil Verify d’Adobe ne semble pas faire cela. Il semblerait qu’il ne s’agisse que de correspondances de chaînes – s’il voit « Leica » dans le nom, il y appose le point rouge. Bien qu’il n’y ait techniquement rien de mal à cela, cela donne une apparence d’authenticité à l’image, rendant plus facile à croire toute autre information falsifiée.

Bien sûr, je ne suis pas le seul à avoir trouvé des façons amusantes de jouer avec le standard CAI. [Dr. Neal Krawetz] sur le blog Hacker Factor, j’ai récemment exploré plusieurs méthodes de falsification d’images, y compris de faux certificats avec une méthode un peu plus simple que celle que j’ai élaborée. Mon processus de génération d’un certificat a nécessité quelques fichiers et différentes commandes, tandis que le sien le distille en un joli one-liner.

Des instantanés sécurisés ?

Alors, si le système ne semble vraiment pas fonctionner très bien, pourquoi des centaines d’organisations médiatiques et technologiques sont-elles impliquées dans le projet ? En tant que consommateur, je ne vais certainement pas payer un supplément pour un appareil photo simplement parce qu’il intègre ces fonctionnalités, alors pourquoi les entreprises dépensent-elles plus pour le faire ? Dans le monde parfait du CAI, toutes les images sont signées selon leur norme lors de leur capture. Il devient facile de savoir immédiatement si une photographie est réelle ou générée par l’IA, et qui est l’artiste original, s’il a choisi d’attacher son nom à l’œuvre. Cela répond à plusieurs objectifs qui pourraient être très utiles aux entreprises qui sponsorisent le projet.

Dans ce monde parfait, Adobe peut s’assurer que toute image utilisée pour former un réseau neuronal génératif a été capturée et non générée. Cela permet d’éviter une condition appelée trouble de l’autophagie du modèle, qui affecte les IA qui se «consanguinent» sur leurs propres données – essentiellement, après quelques générations de recyclage sur les images générées par le modèle, d’étranges artefacts commencent à se développer et à s’amplifier. Imaginez un réseau neuronal entraîné sur des millions de mains à six doigts.

Au crédit d’Adobe, ils ont tendance à être meilleurs que la plupart des autres entreprises en matière d’approvisionnement en données de formation. Leurs premiers modèles génératifs étaient formés uniquement sur des images sur lesquelles ils détenaient des droits, ou étaient explicitement du domaine public ou sous licence ouverte. Ils ont même expliqué comment les créateurs pouvaient attacher une balise « Ne pas entraîner » aux métadonnées CAI, exprimant leur refus d’autoriser l’inclusion de l’image dans les ensembles de données de formation. Bien sûr, savoir si ces balises seront respectées ou non est une autre question, mais en tant que photographe, c’est la principale fonctionnalité des Content Credentials que je trouve utile.

En dehors de cela, cependant, je ne trouve pas beaucoup d’avantages pour les utilisateurs finaux dans les informations d’identification de contenu. Au mieux, cela ressemble à une solution technique bien intentionnée mais malavisée à un problème social, et au pire, cela peut donner de l’authenticité à des images trompeuses ou falsifiées lorsqu’elles sont exploitées. La désinformation, l’éthique de l’IA et les droits d’auteur sont des problèmes complexes qui nécessitent plus qu’un nouveau format de fichier pour être résolus. Pour citer Abraham Lincoln : « Ne croyez pas tout ce que vous lisez sur Internet. »